Existen varios motivos por los que es recomendable y/o necesario añadir el archivo robots.txt a la raíz del dominio de nuestra web.

La orden más habitual añadida es el “disallow” que viene a decirle al Googlebot que no debería visitar y por tanto no indexar, las páginas o conjunto de páginas que le indiquemos seguidamente.

Las típicas páginas como /wp-admin o /acceso que permiten el login al site o en casos de páginas que ya no existen o por motivos de contenido duplicado generado por filtros,…

¿Cómo funciona el robots.txt?

Un ejemplo:

User-agent: *

Disallow: /categoría-A

La primeria línea indica a qué robot afecta dicha orden, en este caso el asterisco (*) significa a todos. Podríamos elegir si Google (Googlebot), Bing (MSNbot),…

La segunda, “/categoría-A” significa que toda URL que empiece por midominio.com/categoría-A no debe ser visitada por el bot y, por tanto, no indexada.

¿Cómo enviar y verificar el archivo robots.txt?

El archivo siempre debe subirse en la raíz de la web. Es decir, midominio.com/robots.txt.

Si queréis verificar si vuestro archivo robots.txt está bloqueando las páginas que realmente deseamos, simplemente tendréis que dar de alta vuestro site en la herramienta Google Webmasters Tool -que es gratuita-.

Dentro de esta herramienta, en de la sección Rastreo encontramos el Probador de robots.txt:

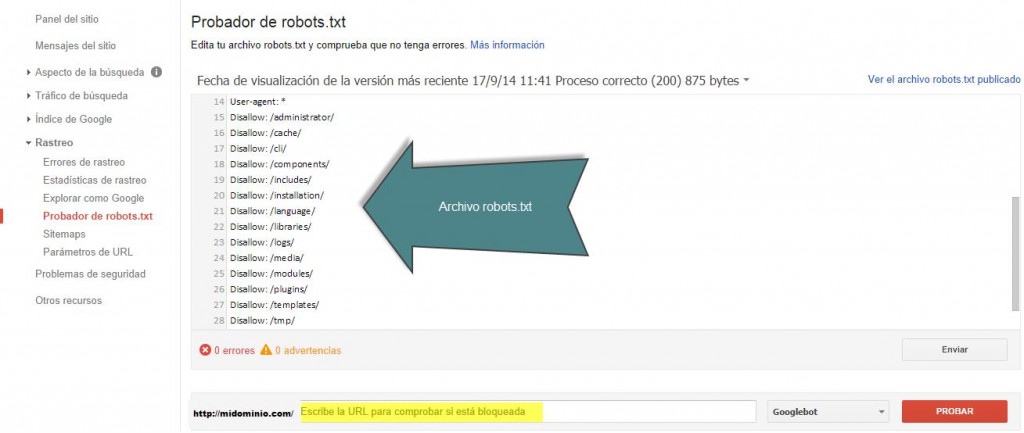

Al acceder nos encontraremos con la siguiente página:

Aquí veremos la última versión del archivo robots.txt -la herramienta nos muestra la fecha de procesamiento- y nos indicará si hay errores o advertencias en el archivo.

En la parte inferior podremos ir probando URLs y Google nos irá diciendo si el acceso a ese página lo tiene PERMITIDO o BLOQUEADO. En el caso de que este bloqueado nos indicará porque línea del archivo se produce el bloqueo.

Además, podemos editar el archivo en la misma herramienta y probar nuestras correcciones. Es importante remarcar que esta edición no actualiza el archivo real robots.txt, sólo es de prueba. Si refrescáis la página volveréis al archivo real.

Deja un comentario